Hopper dostává rychlejší paměti a zvedá výkon

Nvidia loni uvedla na trh akcelerátor H100 s architekturou Hopper a 4nm výrobním procesem. Ten je od té doby jejím nejvýkonnějším GPU pro umělou inteligenci. Teď firma uvádí jeho následníka, GPU označené H200. To ještě není úplně novou generací, ale čímsi jako refreshem, který bude špičkou nabídky Nvidie až do vydání nové generace s architekturou Blackwell. H200 staví na použití rychlejších pamětí, které by ale měly zvednout i celkový výkon.

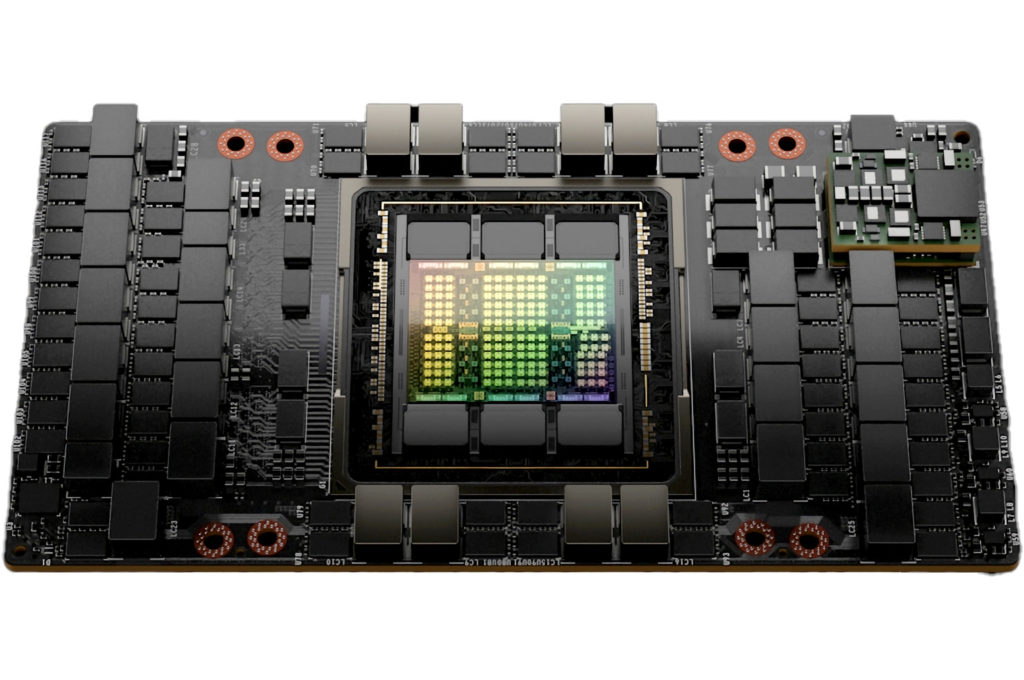

Akcelerátor H200 by měl používat stejný 4nm čip architektury Hopper s 80 miliardami tranzistorů jako H100 a také asi stejné mezaninové provedení. Novinkou je ale osazení paměti HBM3E, kterou by GPU zřejmě mělo používat jako první na trhu. Tato paměť poskytuje kapacitu 141 GB, což je nezvykle nepravidelné číslo – zřejmě jde o 144 GB tvořených šesti 24GB pouzdry HBM3E, ale 3 GB jsou z nějakého důvodu nedostupné.

Otázka je, jestli je používá GPU pro nějaké svoje vyhrazené účely, nebo Nvidia ve spolupráci s výrobci těchto pamětí umí vypnout individuální vrstvy DRAM v pouzdrech s pamětí HBM3E (pokud jsou 24GB pouzdra osmivrstvá, pak by jedné vrstvě DRAM odpovídaly právě 3 GB kapacity). Tímto by se dalo zachránit pouzdro HBM3E s nějakým defektem i po jeho osazení na GPU, zatímco běžně by se muselo celé pouzdro deaktivovat za cenu značené ztráty výkonu a kapacity grafické paměti.

Propustnost paměti dosahuje až 4,8 TB/s, což při 6144bitové sběrnici se šesti pouzdry znamená, že by paměti měly efektivně běžet zhruba na 6400 MHz (6,4 Gb/s na jeden bit šířky). Pro H100 Nvidia uváděla propustnost 3 TB/s, mělo by to tedy být navýšení až o 60 %. Není to dáno jen vyšší frekvencí HBM3E, ale také tím, že je použito plné 6144bitové rozhraní, zatímco H100 používala jen 5120 bitů – aktivních bylo jen pět pouzder HBM3 ze šesti.

Zda se zvýšily frekvence a počet GPU, nevíme. Ve verzi H100 měl čip zapnutých 16 896 shaderů (132 SM) a 528 tensor jader s taktem boostu okolo 1,83 GHz, což dávalo hrubý výkon v FP32 operacích 66,9 TFLOPS a 33,5 TFLOPS v FP64. Při použití tensor jader a 8bitové přesnosti měl teoretický výkon jít až k 2000 TOPS. TDP původní verze bylo 700 W, opět ještě nevíme, zda zůstalo stejné.

Nvidia uvádí, že tato novinka může mít až o 60 % vyšší výkon při inferenci GPT-3 se 175 miliardami parametrů oproti H100, až o 90 % vyšší výkon při inferenci Llama2 se 70 miliardami parametrů a v HPC výpočtech typu simulací může být až 2× rychlejší, ovšem to je ještě proti 7nm A100 generace Ampere, nikoliv proti H100. Pozor ale na to, že jde jen o oficiální benchmarky, které mohou být selektivní a tím zkreslující. Například pokud firma vybrala taková čísla, kde byla úloha dříve silně zpomalena kvůli tomu, že se nevešla do paměti, nebude toto reprezentovat úlohy, které kapacitou limitované nejsou.

H200 bude vyráběn jako samostatný mezaninový akcelerátor (potřebuje tedy speciální desku, zatím nejsou informace o verzi v provedení karty PCI Express). Nvidia také bude nabízet verzi zkombinovanou do jednoho balení s ARM procesorem, pojmenovanou H200 Grace Hopper Superchip.

Na těchto procesorech/GPU je aktuálně stavěn superpočítač Jupiter v německém výpočetním centru Jülich. Půjde o klastr Eviden BullSequana XH300 s něco pod 24 000 Grace Hopper Superchipy. Jeho příkon má být až 18,2 MW a výkon v AI operacích 90 EFLOPS nebo až 1 EFLOPS ve vědeckých výpočtech (čili v FP64). Tento systém by se tak mohl dostat do „exascale“ klubu.

Dostupnost v Q2 2024

Podobně jako to u výpočetních GPU Nvidie (ale i serverových produktů jiných firem) bývá, je nynější odhalení předběžné a reálná dostupnost nastane až o dost později. V případě H200 to má být v druhém kvartálu roku 2024, kdy budou tyto akcelerátory k dostání od výrobců serverů a v cloudových službách. Nvidia sama bude tato GPU (po čtyřech nebo osmi kusech) nabízet ve svých serverech Nvidia HGX.

Zdroj: Nvidia (1, 2) AnandTech

Jan Olšan, redaktor Cnews.cz

⠀